[Hot Toys] Les dernières nouveautés du fabricant - Le plein de figurines 1/6e et de figurines mystères

[Hot Toys] Les dernières nouveautés du fabricant - Le plein de figurines 1/6e et de figurines mystères [News du Lundi] Une analyse de l'influence de Lucas sur le cinéma - Et les novélisations des films continuent de sortir en audiobook !

[News du Lundi] Une analyse de l'influence de Lucas sur le cinéma - Et les novélisations des films continuent de sortir en audiobook ! [Carcassonne] Salon La Guerre des Etoiles : Episode III - L'affiche officielle

[Carcassonne] Salon La Guerre des Etoiles : Episode III - L'affiche officielle The Acolyte : Nouvelle vidéo promo ! - Le plein d'action !

The Acolyte : Nouvelle vidéo promo ! - Le plein d'action !  The Mandalorian And Grogu : Sigourney Weaver pourrait rejoindre le casting du film ! - Une rumeur fiable !

The Mandalorian And Grogu : Sigourney Weaver pourrait rejoindre le casting du film ! - Une rumeur fiable ! [Analyse] Avec Star Wars, la philo tu vaincras - Des pensées philosophiques

[Analyse] Avec Star Wars, la philo tu vaincras - Des pensées philosophiques [Topps] 2024 Throwback Thursday Star Wars Edition - Cartes 55, 56 & 57

[Topps] 2024 Throwback Thursday Star Wars Edition - Cartes 55, 56 & 57 [Analyse] Droit et Star Wars - Des codes, des règles, du juridique, ...

[Analyse] Droit et Star Wars - Des codes, des règles, du juridique, ... [MAJ] [The Black Series] - Les dernières arrivées dans notre base de données - et les annonces du May the 4th

[MAJ] [The Black Series] - Les dernières arrivées dans notre base de données - et les annonces du May the 4th [Vaisseau/Véhicule de la Semaine] N°6 - Destroyer impérial - "Capitaine, les chances de survie dans l'assaut direct d'un croiseur interstellaire…" - "La ferme !"

[Vaisseau/Véhicule de la Semaine] N°6 - Destroyer impérial - "Capitaine, les chances de survie dans l'assaut direct d'un croiseur interstellaire…" - "La ferme !"

Chères lectrices, chers lecteurs,

Vous trouverez ci-dessous la partie mise à jour de l'article sur C3PO. L'article complet est disponible ici : C3PO.

Bonne lecture !

L'intelligence artificielle comme outil ?

Traduire et ajouter une voix par dessus l'original, c'est déjà beaucoup. Mais est-il possible d'aller encore plus loin ?

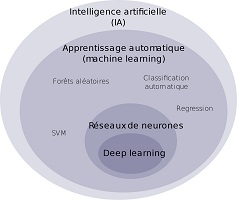

Le "Machine Learning", les "réseaux de neurones" et le "Deep Learning" sont progressivement chassés du vocabulaire populaire actuel par  les "intelligences artificielles (IA)". Ce terme, beaucoup plus générique, est couramment employé pour évoquer toutes les nouveautés ; un peu comme lorsque tout était "quantique". Au-delà d'un simple concept à la mode, l'informatique fait de réels progrès avec certains "robots informatiques".

les "intelligences artificielles (IA)". Ce terme, beaucoup plus générique, est couramment employé pour évoquer toutes les nouveautés ; un peu comme lorsque tout était "quantique". Au-delà d'un simple concept à la mode, l'informatique fait de réels progrès avec certains "robots informatiques".

La société HeyGen propose effectivement d'aller plus loin grâce à une ou plusieurs IA. Pratiquement tout est possible par le croisement des technologies disponibles.

Par exemple, il est possible de faire parler une image dans n'importe quelle langue. Il suffit de sélectionner une image et un texte à lire.

Le résultat global (ci-dessous) est plutôt réussi. Malgré cela, certains mouvements des lèvres sont lents ou approximatifs et on sent bien que l'audio n'est pas naturel et provient d'un logiciel. Cela n'en demeure pas moins une prouesse tout à fait nouvelle dans sa simplicité et sa rapidité de mise en œuvre, gratuitement. Des versions de voix plus naturelles existent, et les meilleures sont bien sûr payantes.

| Image d'origine | Le résultat en vidéo |

Notons qu'il existe déjà des logiciels d'apprentissage du timbre de la voix par intelligence artificielle. Ces derniers permettent d'explorer encore d'autres pistes. Sans doute qu'HeyGen intègre justement cet "imitateur de voix", car il est également possible de traduire une vidéo. Là où le résultat se différencie de Skype Translator, par exemple, c'est que ce n'est pas seulement l'audio qui est traduit, mais aussi les mouvements des lèvres qui s'adaptent à la nouvelle langue parlée. De plus, la voix originale ne change que très peu.

J'ai donc demandé à HeyGen de traduire en anglais (avec accent américain) et en japonais la version française d'Ahsoka (Olivia Luccioni est la comédienne qui double en français Rosario Dawson).

Voici le résultat :

| En "américain" | En japonais |

La plupart des retours (des gens dont c'est la langue maternelle) sont positifs. Rappelons que l'on part d'une simple image au départ !

Je reconnais que je ne peux pas vous parler du japonais sur le fond. En tout cas, dans les deux cas, on reconnaît le timbre de voix d'Olivia Luccioni. La tonalité, le rythme et les accents toniques des langues sont respectés alors que c'est sans doute ce qui est le plus dur à reproduire. Ici, le texte est lu comme un comédien le lirait dans sa propre langue. Cependant, on peut noter qu'avec toutes ces manipulations on s'éloigne légèrement de la qualité visuelle de la première image fixe (j'ai également compressé les vidéos).

Comment font-ils ? Concrètement, l'IA ajoute un masque sur la vidéo originale afin d'intégrer de nouveaux mouvements de lèvres et de perfectionner la synchronisation labiale. Un peu comme un deepfake qui respecterait l'image d'origine. Il n'est donc pas possible de faire entrer dans cette zone quelque chose d'étranger (une main, un verre d'eau, etc), au risque de voir apparaître une pixellisation aux abords du détourage automatique.

Bien sûr, tout n'est pas parfait dans son ensemble. En revanche, c'est amplement suffisant pour faire passer un message publicitaire s'adressant à l'international. Selon HeyGen, les entreprises et startups feraient partie de leurs premières cibles commerciales.

Les "créateurs de contenus" sur YouTube, Instagram, TikTok, Facebook, etc, sont directement visés par HeyGen qui leur propose des solutions de mise en ligne simplifiées pour leurs contenus et la création de nombreux produits : avatars, modèles de vidéo, vidéos complètes, etc.

Pour envoyer une vidéo à traduire chez HeyGen, c'est gratuit et très rapide, en revanche c'est beaucoup plus long pour recevoir le résultat. Au moment de faire ces tests, il existait une file d'attente de plus de 75 000 personnes... C'était une catastrophe. Bien sûr, la startup a bien conscience de cette longue attente et propose d'ailleurs des tarifs "creator", "business", "enterprise" afin de réduire le délai (entre autres options). C'est son modèle économique. Lorsque vous êtes en gratuit, vous observez donc la file d'attente faire un yoyo interminable dans l'avancement de votre position quasi stagnante... les membres payants vous passent régulièrement devant. Il m'a fallu pas moins de 7 jours pour obtenir une seule vidéo... Cela convaincra probablement les plus impatients de payer et découragera les simples curieux.

Au-delà de la possibilité de faire briller sa communication d'entreprise, il n'est pas difficile de se rendre compte du véritable problème que peut poser ce même outil dans d'autres cas de figure.

Le travail fantastique accompli par les comédiens de doublage est clairement menacé. De plus, la technique du doublage n'est pas utilisée partout dans le monde. Si demain, les voix d'origine des acteurs sont conservées mais traduite à l'écran de cette façon, c'est tout le marché du cinéma qui pourrait changer... et le comédien de doublage n'aurait plus de travail. Forcément, le résultat parfois brouillon n'a pas de quoi faire trembler les comédiens de doublage, pour l'instant, mais... dans quelques années ? L'IA sera t-elle capable de reproduire fidèlement les émotions... et les trémolos dans la voix ? Ce que vous avez sous les yeux n'est que le début d'une révolution plus ou moins silencieuse. Les films et les séries seront-ils traduits de cette façon ? Ou peut-être que ce logiciel viendra compléter le travail des comédiens de doublage, main dans la main...?

Ce bouleversement arrive, que ce soit dans le cas d'un film ou d'une série, on l'a vu, mais sans doute, plus rapidement, dans le monde du jeu vidéo. Là où une voix n'est pas clairement associée à une personne physique réelle ou un personnage iconnique (comme les PNJ), il suffira de donner un texte à faire lire dans toutes les langues. Aucun comédien n'aura à lire le texte car l'IA est capable de tout gérer, de la lecture naturelle à la traduction. Idem avec les dessins animés et les "voix off", l'IA ira chercher une voix dans sa banque de donnée et n'aura plus qu'à lire le texte.

D'un autre côté, certains films, séries et jeux vidéo disponibles uniquement en version originale et/ou version originale sous-titrée pourront enfin être traduits à l'image.

TOUS les films pourraient être repris pour avoir un labial qui correspondrait à la langue doublée... de la création du cinéma jusqu'à aujourd'hui ! Mais aussi des documentaires, des interviews, des vidéos d'archives... Il serait peu-être même possible un jour d'écouter une chanson étrangère dans sa voix "d'origine" mais traduite dans la langue que l'on souhaite.

Il reste à régler les rares erreurs de traductions qui peuvent être liées aux expressions idiomatiques ou aux problèmes culturels. Elles sont plus complexes à être détectées mais elles finiront probablement par être éliminées les unes après les autres. Si la puissance de calcul le permet, d'ici quelques années, il serait même possible d'obtenir le résultat de la vidéo ou simplement de l'audio en quasi-direct. Cette fois, C3PO et tous les traducteurs de la planète seraient menacés.

Certaines applications mobiles comme le très célèbre Google Traduction (ou son équivalent Apple Translate) possèdent l'option "conversation". Avec cette application, il est déjà possible de parler dans une langue étrangère avec un simple décalage de quelques secondes (comme Skype Translator). La réponse de l'interlocuteur est également détectée et traduite en retour. Mais les résutats peuvent être médiocres pour plusieurs raison : langue de traduction peu utilisée, mauvaise articulation, mot-à-mot, phrases incomplètes, patois, etc. L'outil de traduction ne pourra pas faire de miracle. L'étape de la reconnaissance vocale, de plus en plus développée, reste incontournable. Pour l'améliorer, il existe des logiciels permettant d'éduquer individuellement cette reconnaissance vocale (depuis 1997 dans le commerce). Simple d'utilisation, ce procédé pourrait être un préalable à l'utilisation d'un traducteur plus puissant. La future puissance de traitement et les progrès qu'elle génèrera permettront de démocratiser l'accès à la traduction. Vous pourrez sans problème imaginer faire un tour du Monde à pied avec un simple micro serre-tête.

En parallèle, les diplomates continueront probablement pendant de nombreuses années à faire appel à un traducteur en chair et en os, ne serait-ce que pour éviter de funestes conséquences.

Mais que penser de la possibilité de faire dire ce que l'on veut à n'importe quelle photo ou vidéo ? Il sufit de choisir un texte, une langue, un timbre de voix et une vidéo ou une image... le tour est joué. Que penser de la multiplication des "deepfakes" ? Utiliser la voix ou l'image de personnes vivantes ou décédées pose aussi de nouvelles questions. Reste donc à savoir quel sera le cadre légal, s'il sera internationnal, s'il pourra permettre d'éviter les abus et s'il déterminera clairement les droits de chacun.

C3PO existera-t-il vraiment un jour ?

Le droïde protocolaire qu’est C3PO n’est pas utopique et pourrais être très utile. Mais il aura sans doute une apparence humaine.

Tout est possible ! le meilleur, comme le pire... Juste Ciel ! Une fois encore, il semblerait que C3PO n'en croit pas ses yeux de droïde !

Vous pouvez toujours retrouver en un clic l'intégralité du dossier Quand la science rattrape Star Wars.

A bientôt dans notre galaxie !

-

Va t'on découvrir sur Mimas des traces d'une ancienne bataille ?

Ah non je confonds avec Minas Tirith

C'est fou comme les dimensions deviennent énormes par rapport à la Terre.

Une épaisseur de glace de 20-30km, c'est fou. -

Ça fait un beau trou à creuser pour trouver du poisson

-

Xendor a écrit:Ça fait un beau trou à creuser pour trouver du poisson

Boaf, avec le réchauffement climatique, l'eau sera bientôt accessible directement.

Sympa ces mises à jour. Ces domaines évoluent vite, c'est pas facile de rester à la page.

-

Ce que je trouve énorme avec Mimas c'est que t'as un doctorant qui fait une thèse en se posant des questions là-dessus, un an après sa soutenance il publie des conclusions au sujet de la coquille de glace, puis, presque 10 ans plus tard, son directeur confirme les prédictions grâce à une approche à peine différente. C'est un travail sur la durée...

Quant à l'IA, je ne vais pas faire un article toutes les semaines, mais il y aurait presque de quoi. Ça bouge très vite dans ce domaine

-

ashlack a écrit:Xendor a écrit:Ça fait un beau trou à creuser pour trouver du poisson

Boaf, avec le réchauffement climatique, l'eau sera bientôt accessible directement.

Xendor a écrit:Ce que je trouve énorme avec Mimas c'est que t'as un doctorant qui fait une thèse en se posant des questions là-dessus, un an après sa soutenance il publie des conclusions au sujet de la coquille de glace, puis, presque 10 ans plus tard, son directeur confirme les prédictions grâce à une approche à peine différente. C'est un travail sur la durée...

Xendor a écrit:Ce que je trouve énorme avec Mimas c'est que t'as un doctorant qui fait une thèse en se posant des questions là-dessus, un an après sa soutenance il publie des conclusions au sujet de la coquille de glace, puis, presque 10 ans plus tard, son directeur confirme les prédictions grâce à une approche à peine différente. C'est un travail sur la durée... :

:

C'est le but des Doctorants et Directeurs de thèses ? Non ? ... avancer dans la recherche ... peu importe le domaine ^^

Une thèse, avant d'être publier, se doit d'être validité par cette soutenance pour faire justement avancer la recherche par des questions interessantes durant cette soutenance (le pourquoi, le comment, quel avenir ?) Pour quelle soit modifiée et affinée surtout.

Elle doit logiquement et normalement compléter les recherches déjà faites sur un sujet ... et amener d'autres personnes à y réfléchir dans un futur proche.

Sans ceci, on ne saurait rien sur nos origines, quelles qu'elles soient, dans tous les domaines de compétence.

La recherche, toujours la recherche : c'est le mot d'ordre, d'après mon expérience. -

Oui je n'ai pas le dit le contraire. Et d'ailleurs là c'est d'abord le doctorant qui a repris ses travaux, pas quelqu'un d'autre (ce qui est somme toute assez classique). Mais surtout le sujet n'était pas le même, même si on voit bien que Radwan Tajeddine a une passion pour Mimas. C'est Valery Lainey (donc son directeur de thèse) qui a repris les travaux, donc pas ceux de la thèse, mais ceux de la recherche et publication post-thèse, avec une approche différente. Et ça a pris une ampleur internationale (un anglais et un chinois dans l'équipe). Bref, je trouve ça plutôt chouette, c'est tout ce que je disaisKessel a écrit:C'est le but des Doctorants et Directeurs de thèses ? Non ? ... avancer dans la recherche ... peu importe le domaine ^^

Pour les plus curieux :

Le résume de la thèse de Radwan Tajeddine de 2013.

L'article publié par la NASA en 2014.

La publication du 07/02/2024 dans Nature.

Je pense que les url finiront par sauter. -

Pour ceux qui voient de qui il s'agit, Peter Higgs, prix Nobel de physique en 2013, est décédé le 08 avril à l'âge de 93 ans. Il avait émis l’hypothèse du fameux "boson de Higgs" en 1964 ; hypothèse qui a finalement été confirmée en juillet 2012. Très discret de son vivant, je pense néanmoins qu'il entre dans l'Histoire de la physique et trouvera un jour sa place dans des manuels scolaires.

L'actualité de 2012 sur le boson de Higgs

L'article sur la Force -

-

Merci de votre compréhension.

- Mimas. Ce n'est pas une lune...

- [Parodie] L'Empire de Bruno Dumont

- Un faux sabre laser sur Mars...

- Un exosquelette fonctionnel

- Mégastructures spatiales

- [MAJ] Un nouveau sabre laser

- Il y a bien longtemps, dans une galaxie microscopique...

- [MAJ J21] Mise à jour du dossier "Science et Star Wars"

- [MAJ] Premier vol privé vers la Station Spatiale Internationale

- Comment faire taire Jar Jar Binks ?

Vous avez une information concernant l'Univers Star Wars que vous voulez partager avec d'autres internautes ?

Vous avez une information concernant l'Univers Star Wars que vous voulez partager avec d'autres internautes ?

Vous pouvez nous la proposer facilement : cliquez ici !